<잇(IT)터뷰 전체 영상 보기>

잇(IT)터뷰 전체 내용은 ▼아래 영상▼에서 확인해 주세요!

◼ 게스트 : 김승우 이사 / SUSE Korea, 문성호 차장 / 다올티에스 (marketing-kr@suse.com)

◼ 진행자 : 고우성 PD / 토크아이티 (talkit@talkit.tv, https://talkit.tv/)

영상 목차

◼ 아래 각 목차를 클릭하시면 해당 내용을 영상으로 바로 보실 수 있습니다.

✔ AI 시대의 기본 플랫폼, 쿠버네티스

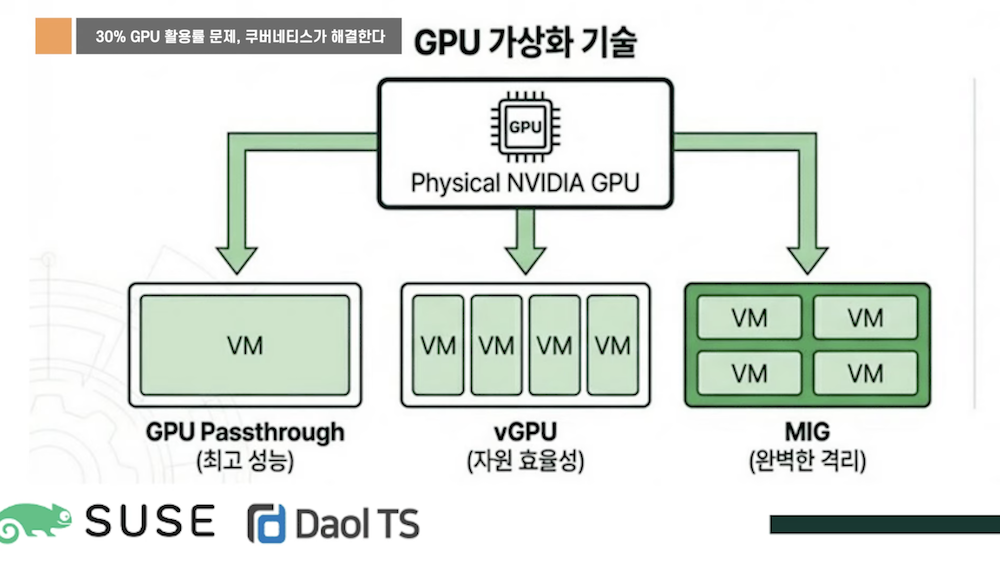

✔ 30% GPU 활용률 문제, 쿠버네티스가 해결한다

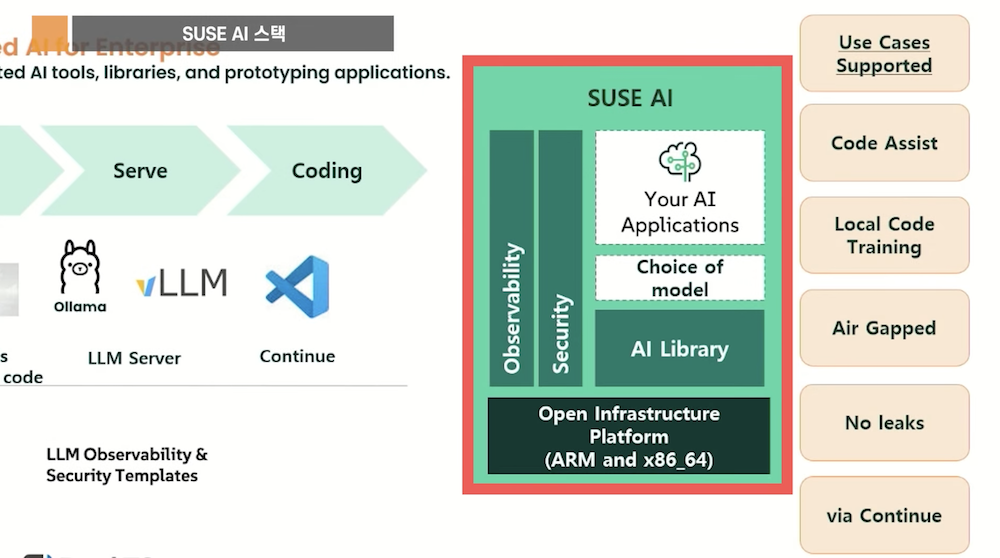

✔ SUSE AI 스택

✔ 15GB에서 100MB로, OS 경량화

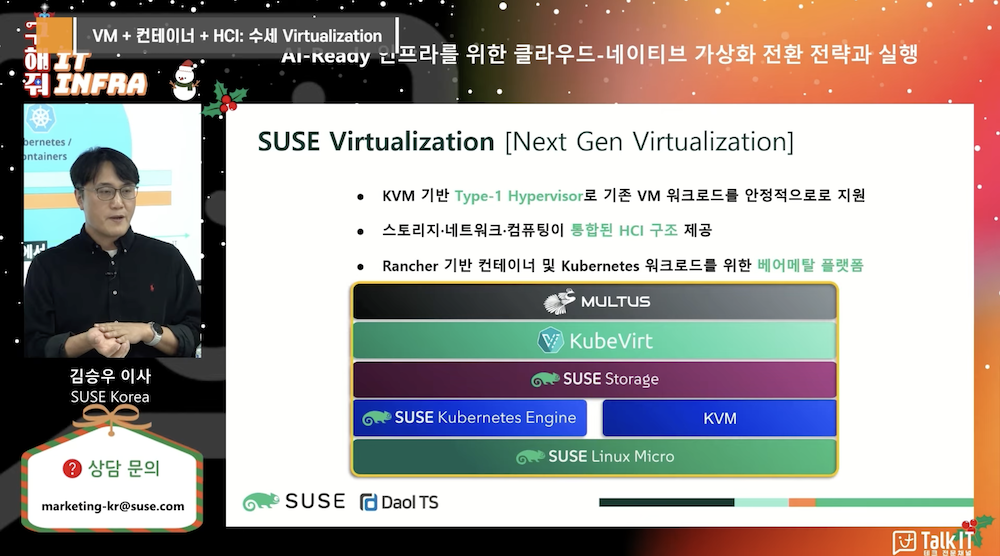

✔ VM + 컨테이너 + HCI: 수세 Virtualization

<잇(IT)터뷰 – 핵심 내용 파악하기>

‘잇(IT)터뷰 – 핵심 내용 파악하기’는 영상의 핵심 내용을 정리한 글입니다.

|

이번 잇(IT)터뷰는 AI 확산의 핵심 과제로 “운영 속도”와 “GPU 활용 효율”을 짚고, 기존 VM 중심 인프라가 느린 배포/회수와 낮은 GPU 활용률 문제에 부딪히는 상황에서 쿠버네티스 기반 컨테이너 운영이 왜 표준이 되는지를 설명합니다.

또한 오픈소스 AI 라이브러리의 취약점 관리, ARM·x86을 아우르는 AI 플랫폼(SUSE AI), 공격면을 줄이는 초경량·불변(Immutable) OS, 그리고 VM/컨테이너를 함께 운영하는 가상화 전환 전략(SUSE Virtualization)까지 “AI 인프라 스택” 관점에서 정리합니다.

1. AI 확산의 2가지 과제: 운영 속도와 GPU 효율

AI가 기업에 확산될수록 먼저 부딪히는 과제는 두 가지다.

첫째, 모델을 빠르게 학습하고 빠르게 배포·서빙한 뒤 필요하면 즉시 회수할 수 있는 운영 속도다.

둘째, 비싼 GPU를 고정적으로 묶어 두지 않고 워크로드에 맞춰 최대한 효율적으로 쓰는 문제다.

VM 중심 인프라는 이 지점에서 한계가 생긴다. GPU는 한 번 할당되면 고정되기 쉬워 활용률이 낮아지고, 모델은 빠르게 확장·회수해야 하는데 속도가 나오지 않는다. 그래서 AI 워크로드는 컨테이너와 쿠버네티스, 그리고 동적 GPU 스케줄링 환경으로 이동한다.

2. AI 시대의 기본 플랫폼이 쿠버네티스인 이유

AI 운영은 “빨리 학습 → 빨리 서빙 → 빨리 배포/회수”가 반복된다.

이 속도를 내기 좋은 단위가 컨테이너이고, 컨테이너를 오케스트레이션(배포/확장/회수/복구)해 주는 플랫폼이 쿠버네티스다.

또한 AI 패키지/라이브러리는 오픈소스가 많고, 배포 단위가 컨테이너인 경우가 많다. AI 에이전트처럼 기업 시스템 곳곳에서 여러 형태로 돌아갈 워크로드가 늘수록, 무거운 VM보다 컨테이너/쿠버네티스 쪽이 더 적합하다는 흐름을 제시한다.

3. “30% GPU 활용률” 문제와 VM의 구조적 한계

VM 환경에서 GPU를 쓰는 방식(패스스루, vGPU)은 공통적으로 “할당되면 고립되는” 문제가 생기기 쉽다.

패스스루는 하이퍼바이저가 제어권을 놓고 VM이 물리 GPU를 직접 잡는 구조라, 하이퍼바이저 레벨에서 재분배/공유/유연한 핸들링이 어려워진다. vGPU도 유사하게 유연한 재할당이 제한된다.

반면 컨테이너/쿠버네티스 환경에서는 트래픽(로드)에 맞춰 스케일 아웃으로 병렬 처리하고, 로드가 끝나면 할당 리소스를 회수해 다른 워크로드에 재할당하는 식의 “다이나믹한 운영”이 가능해진다. 결과적으로 GPU를 더 유연하게 써서 활용률을 높일 수 있다는 구조를 설명한다.

4. SUSE AI 스택: 오픈소스 AI 라이브러리를 “검증된 이미지”로 운영

AI 운영의 큰 리스크 중 하나는 오픈소스 라이브러리 취약점이다.

영상에서는 SUSE AI가 AI 애플리케이션 운영 고객을 위한 플랫폼이며, AI 라이브러리를 “모아두는 것”에 그치지 않고 업데이트/버그픽스/취약점 대응까지 책임지고 검증된 컨테이너 이미지를 제공하는 방향을 설명한다.

또한 엔터프라이즈는 x86이 많지만, 엣지·특정 산업 영역에서는 ARM 수요도 커지고 있어 ARM과 x86 모두에서 동작하는 통합 플랫폼을 제공한다는 포인트가 나온다.

5. 15GB에서 100MB로: OS 경량화와 Immutable OS의 의미

OS가 커질수록 내장 컴포넌트가 늘어나고, 그만큼 보안 노출점도 많아진다.

클라우드 네이티브 전환이 진행될수록 “꼭 필요한 기능만 남기는 경량화”가 중요해진다는 관점을 제시한다.

가상화 기준으로 설치 미디어가 15GB까지 커진 전통적 OS 흐름과 달리, 필수 기능만 남겨 약 100MB 수준으로 경량화한 MicroOS 계열 접근을 설명한다.

또한 불변(Immutable) OS는 읽기 전용(구성 변경 불가) 구조라 외부 침입자가 시스템 구성을 바꾸거나 악성 코드를 심는 공격 자체를 어렵게 만들어, 구조적으로 방어력을 높인다는 논리를 제시한다.

6. VM과 쿠버네티스를 함께 쓰는 과도기: 복잡성을 줄이는 가상화 전략

기업이 한 번에 클라우드 네이티브로 점프하기는 어렵기 때문에, VM과 쿠버네티스를 함께 쓰는 과도기를 거치게 된다.

하지만 레거시 방식으로는 “VM 생성 → 그 안에 런타임 설치 → 컨테이너 실행”으로 계층이 늘어나 오버헤드가 커지고, 자원 활용률 저하, 운영 포인트 증가, 장애 확률 증가로 이어질 수 있다.

이에 대한 해법으로 SUSE Virtualization을 다음 구조로 설명한다.

경량화된 SUSE MicroOS 위에 KVM 기반 가상화(예: kubevirt 계열 내재)를 올리고, VM과 컨테이너를 함께 관리한다. 또한 HCI 성격으로 SDS(스토리지)를 포함해 로컬 디스크를 묶어 활용하고, 멀티 네트워크 인터페이스 지원까지 포함해 운영 복잡성을 줄이는 방향을 제시한다.

7. 3줄 요약 (핵심만)

– AI 운영은 “빠른 배포/회수”와 “GPU 효율”이 핵심 과제이며, VM 중심 인프라는 구조적으로 한계가 생긴다.

– 쿠버네티스는 컨테이너 기반의 빠른 오케스트레이션과 동적 리소스(GPU) 스케줄링으로 AI 워크로드에 최적화된 기본 플랫폼이 된다.

– SUSE는 검증된 AI 라이브러리 이미지(SUSE AI), 초경량·불변 OS(MicroOS), VM/컨테이너/HCI를 함께 운영하는 가상화(SUSE Virtualization)로 AI 인프라 전환 스택을 제시한다.

◼ 전체 잇(IT)터뷰 내용은 ▶영상으로 바로 가기(클릭)◀에서 확인하실 수 있습니다.

|

◼ 콘텐츠 & 웨비나 문의 : marketing@talkit.tv, 02-565-0012

Copyright ⓒ 토크아이티 All rights reserved. 무단 전재 및 재배포 금지.