<잇(IT)터뷰 전체 영상 보기>

잇(IT)터뷰 전체 내용은 ▼아래 영상▼에서 확인해 주세요!

◼ 게스트 : 오세진 대표 / (주)텐

◼ 진행자 : 고우성 PD / 토크아이티 (wsko@talkit.tv, https://talkit.tv/)

영상 목차

◼ 아래 각 목차를 클릭하시면 해당 내용을 영상으로 바로 보실 수 있습니다.

✔ AI 인퍼런스 시장 확산

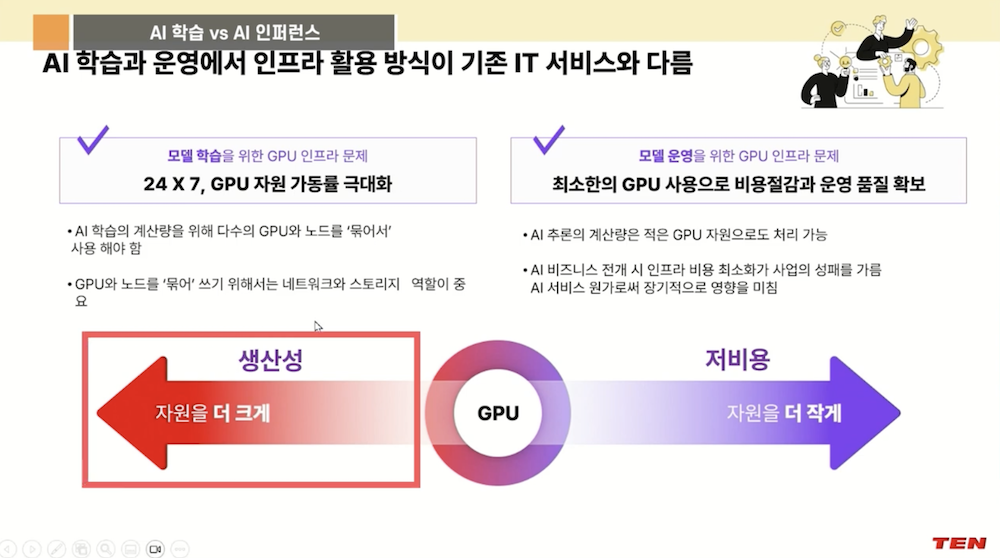

✔ AI 학습 vs AI 인퍼런스

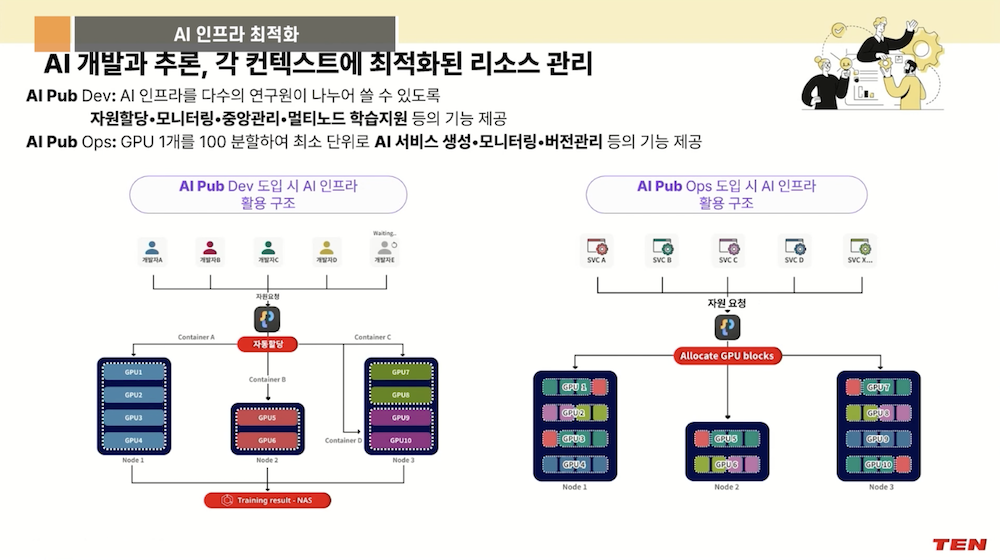

✔ AI 인프라 최적화

이번 잇(IT)터뷰는 AI 추론(inference) 운영 시 경비 절감이 핵심임을 강조합니다. AI 프로젝트가 탐색 단계를 넘어 실제 서비스 적용 단계로 나아감에 따라, AI 학습과 추론의 차이점을 이해하고 운영 비용을 최적화하는 것이 중요해졌습니다.

특히, LLM 서비스와 같은 GPU 사용 서비스는 운영 비용이 높기 때문에, 모델과 인프라를 함께 최적화하여 효율성을 극대화해야 합니다. AI 인프라 사이징을 통해 서비스 목표에 맞는 GPU 자원을 정확히 할당하고, 자원 분할 및 측정으로 비용 효율적인 운영이 가능함을 설명합니다.

결국, AI 추론의 성공은 비용 효율적인 인프라 구축에 달려 있음을 시사합니다.

<잇(IT)터뷰 – 핵심 내용 파악하기>

‘잇(IT)터뷰 – 핵심 내용 파악하기’는 영상의 핵심 내용을 정리한 글입니다.

|

1. AI 추론으로 전환하는 기업의 변화와 비용 절감 전략

– 최근 기업들은 AI 학습보다 인퍼런스에 더 많은 관심을 가지며, 빠른 적용과 운영이 중요해지고 있다.

– 인퍼런스 서비스의 운영 비용은 주로 GPU 서버 비용으로, 비용 부담을 최소화하는 계획이 필수적이다.

– 학습과 운영 각각에서 자원 활용과 인프라 최적화가 성능 향상과 비용 절감의 핵심이다.

– 모델 크기와 인프라의 적절한 조합을 통해 비용 효율성과 성능 모두를 최적화해야 한다.

– 다양한 에이전트와 트래픽 요구에 맞는 자원 할당이 필요하며, 과도한 자원 배분은 낭비를 초래한다.

– 인프라와 모델의 최적화된 병행 설계가 비용 절감과 효율적 운영의 핵심이다.

2. AI 추론 단계로 전환하는 기업들의 흐름

– 최근 기업들은 AI를 단순 실험 단계에서 벗어나 실제 서비스에 적용하는 AI 추론(인퍼런스) 단계로 빠르게 이동하고 있다.

– AI 학습과 추론은 목적과 중요성이 달라며, 특히 추론에 더 집중하는 방향으로 변화하고 있다.

– 2~3년 전에는 AI 프로젝트가 토이 프로젝트 수준에 머물렀지만, 지금은 LM(대형 언어모델)의 대중화로 바로 적용하는 사례가 늘고 있다.

– 기업들은 내부·외부 모두 즉각적 적용 가능성에 더 관심을 가지며, AI 도입의 움직임이 활발해지고 있다.

3. 인퍼런스 운영비용 절감이 중요한 이유

– 인퍼런스는 사용자 수에 상관없이 운영 비용이 매우 높은 핵심 이슈이다.

– 대부분의 비용은 GPU 서버 비용에서 발생하며, 이는 전체 서비스 비용의 큰 부분을 차지한다.

– 비용이 효과보다 너무 커지면 도입 자체가 어려워질 수 있어, 초기 비용 계획이 매우 중요하다.

– 운영비용 절감 방안은 수익성과 효율성 개선을 위해 필수적이다.

4. 학습 자원과 GPU 비용의 중요성

– GPU H는 5~6억 원으로 매우 비싸며, 많은 사람들이 이를 사용하고자 한다는 점이 강조된다.

– 학습 시 높은 자원 투입은 생산성을 극대화하기 위한 필수 조건이다.

– 많은 요청에 대응하기 위해 효율적 오케스트레이션이 중요하며, 빠른 속도로 워크로드를 처리하는 것이 관건이다.

*운영 비용 절감과 하드웨어 최적화

– GPU 자원은 운영 비용의 핵심으로, 하드웨어 비용을 줄이기 위해 모델 축소와 SLM 사용이 추진된다.

– 모델을 축소하더라도 적합한 인프라 배치가 수반되어야 하며, 무작위 인프라 배치는 효율성 저하를 초래한다.

– 인프라는 필요한 만큼만 효율적으로 배치해야 하며, 과도한 인프라는 불필요한 비용 증가를 의미한다.

5. 모델과 인프라 최적화의 필요성

– 인퍼런스 서비스는 여러 에이전트와 다양한 모델을 목적에 맞게 운영하므로, 하나의 모델 또는 인프라로는 충분하지 않다.

– 에이전트별로 요구하는 GPU 자원 크기와 트래픽이 다르기 때문에 각각에 맞게 최적화된 자원 할당이 중요하다.

– GPU 자원을 특정 목적에 맞게 최소한으로 할당하여 전체 서비스 효율성과 비용 절감을 달성할 수 있다.

– 자원 요청 시, 과도한 할당은 비용 증가와 다른 서비스 자원 부족 문제를 야기하므로 필요에 맞게 효율적으로 제공하는 것이 중요하다.

– 이러한 최적화와 계획이 비용 절감과 안정적인 서비스 운영의 핵심임을 강조한다.

6. GPU와 컨테이너 기반 리소스 할당 방식

– GPU는 실제 운영시 모델에 따라 벡터 DB 등 작은 모델들도 함께 사용되며, 이때 GPU 한 장에 여러 컨테이너를 띄워야 할 때가 있다.

– 컨테이너는 GPU 유닛 단위로만 할당 가능하여, 작은 모델도 GPU 전체를 할당받거나 여러 컨테이너로 나눠야 한다.

– 모델의 자원 필요량을 정확히 측정하기 어려운 상황을 해결하기 위해, 자원 분할 방식을 도입하였다.

*GPU 자원 분할 및 블록으로의 세분화

– GPU의 연산 코어와 메모리 자원을 각각 100분할하여 더 정밀한 배분이 가능하게 만든다 .

– 이 100개 조각은 ‘블록’이라고 부르며, 각 서비스는 할당받은 블록 수로 운영 상태를 측정한다.

– 예를 들어, 특정 모델이 17개 블록을 사용하는 경우, 해당 자원 사용량은 17%로 할당되며, 이는 고정된 자원 배분을 의미한다.

*멀티테넌시와 독립적 프로세싱

각 컨테이너는 특정 블록으로만 프로세싱을 수행하며, 다른 컨테이너와 자원이 겹치지 않는다 .

이 방식은 여러 서비스가 배타적으로 자원을 점유하지 않고, 멀티테넌스 환경에서도 효율성을 높인다.

7. 자원 할당과 서비스 운영 최적화

– 서비스의 자원 할당은 초과하지 않도록 조절해야 하며, 이를 통해 안정적인 운영이 가능하다고 설명한다.

– 자원 측정을 통해 특정 서비스의 처리 속도와 자원 요구량을 파악하는 것이 중요하다.

– 예를 들어, 1초에 한 콜 처리하는 서비스가 예상보다 5배 빠른 요청이 들어오면, GPU 한 대로 커버 가능하다는 것을 알 수 있다.

– 이와 같은 측정을 통해, 도입 전 필요한 자원 규모(사이징)를 미리 계획할 수 있어 사업적 메리트가 크다고 주장한다.

– 분할되지 않은 상황에서는 효율적 사이징이 어렵다는 점도 언급된다.

*자원 측정과 성능 향상 방법

– 자원을 더 투입하면 응답 속도는 빨라진다는 원리를 설명하며, 이는 고객 목표에 맞춘 성능 조절이 가능하다고 한다.

– 고객은 목표 응답 시간(예: 1초 이하, 밀리세컨드 단위)에 따라 적절한 자원 배분을 결정할 수 있으며, 블로그 형태의 가이드라인을 제공한다.

– 자원 조절을 통해, 최소 자원으로도 요구하는 수준의 서비스 가능을 목표로 할 수 있다고 강조한다.

– 이를 위해, 고객이 판단할 수 있도록 자원과 속도 간의 관계를 보여주는 지표를 제공하는 것이 필요하다고 설명한다.

◼ 전체 잇(IT)터뷰 내용은 ▶영상으로 바로 가기(클릭)◀에서 확인하실 수 있습니다.

|

◼ 콘텐츠 & 웨비나 문의 : marketing@talkit.tv, 02-565-0012

Copyright ⓒ 토크아이티 All rights reserved. 무단 전재 및 재배포 금지.